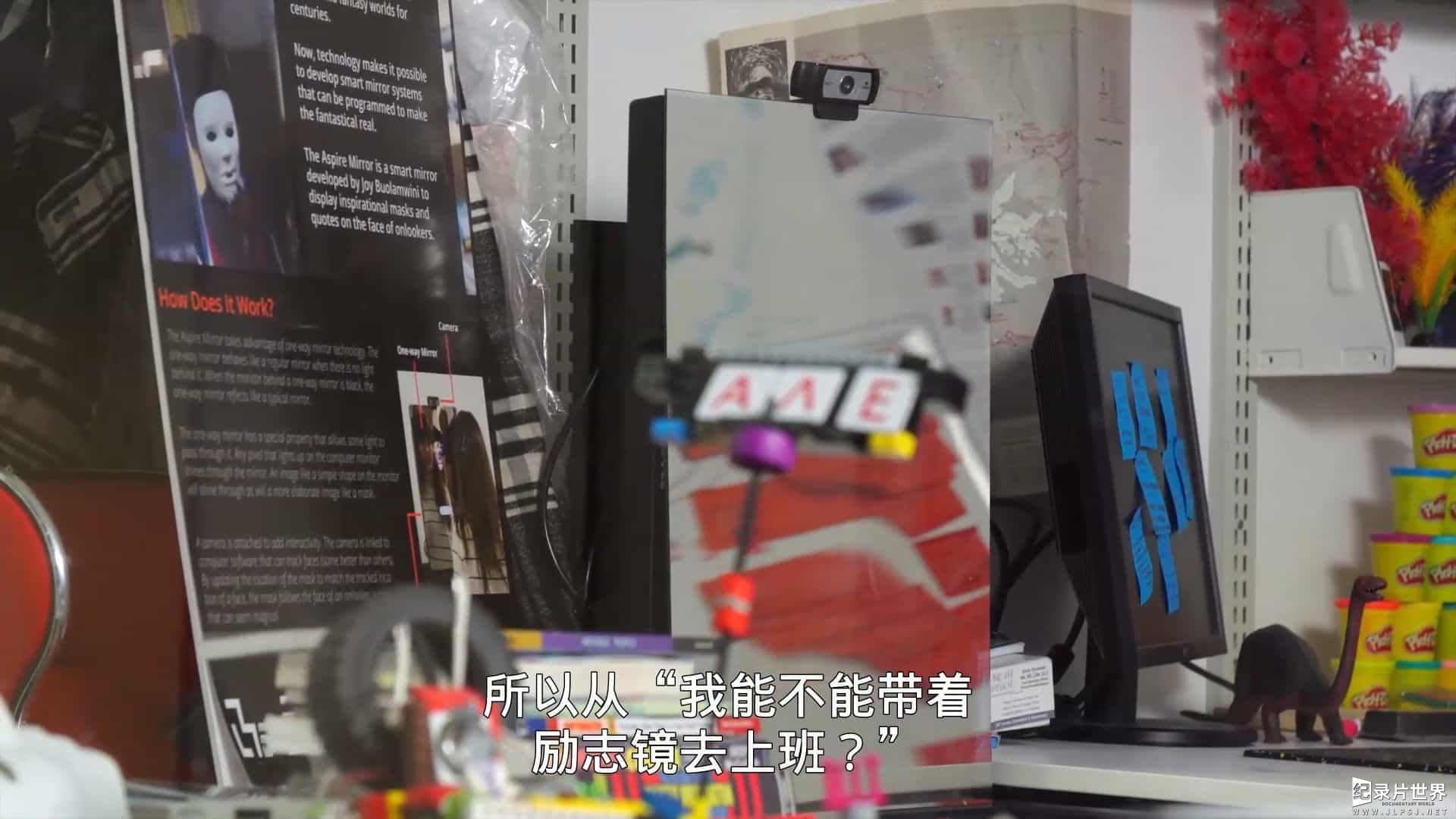

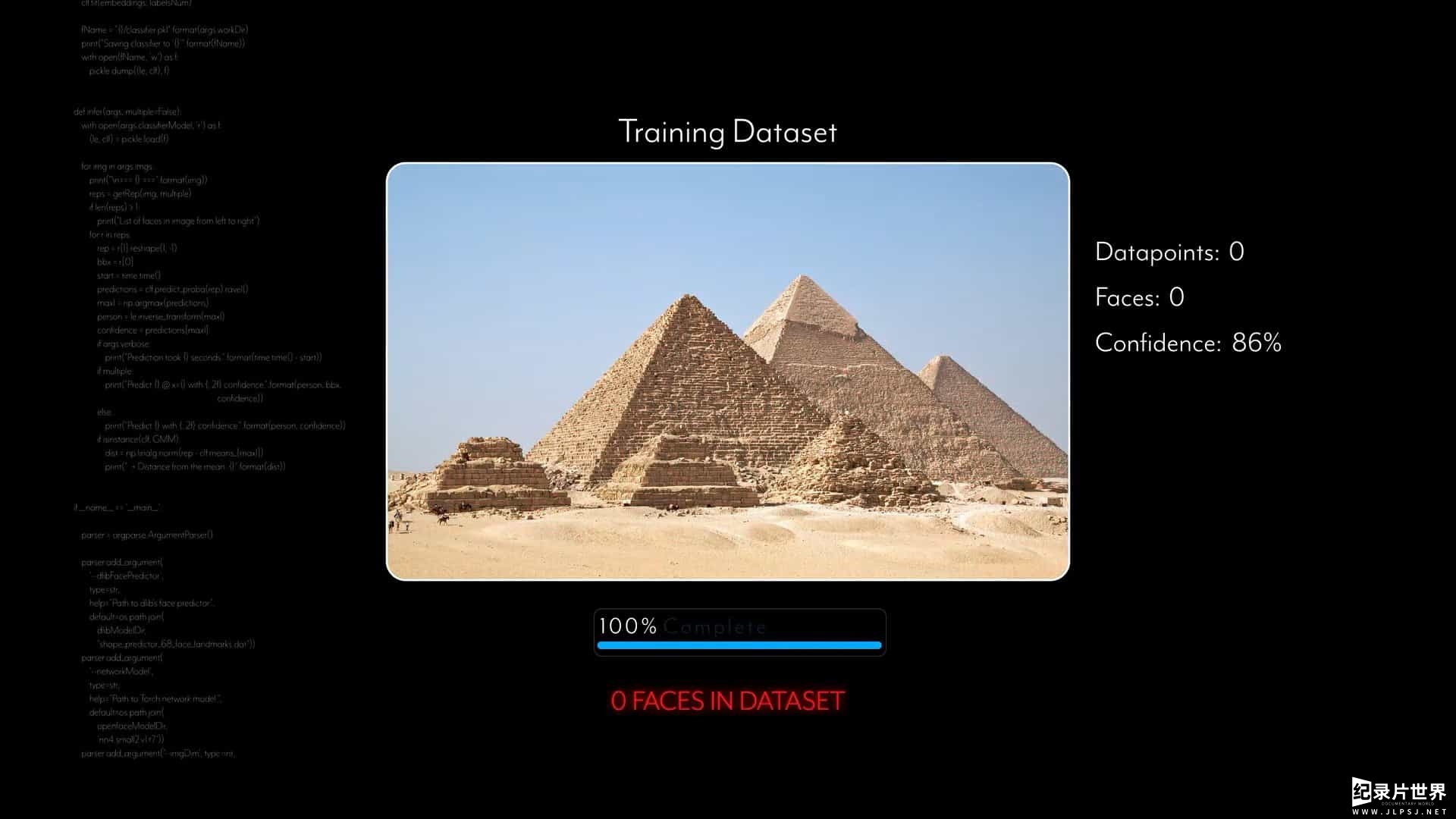

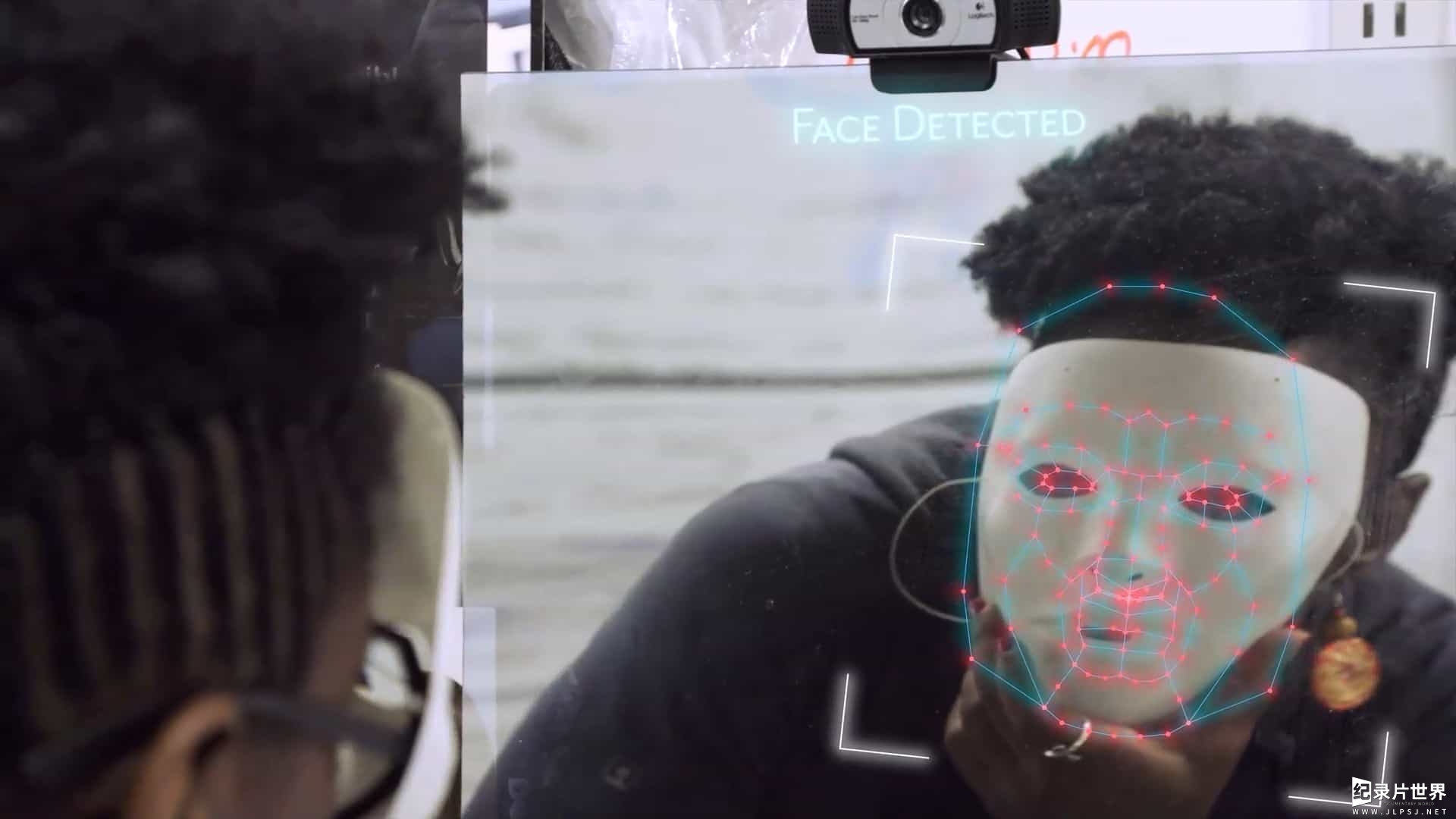

麻省理工学院媒体实验室的研究员乔伊·波罗瓦尼发现了人脸识别技术的缺陷,Netflix纪录片《编码歧视 Coded Bias 2020》对于算法的偏见进行了探讨。HIFF 人脸识别技术隐含的种族与性别歧视,及其广泛使用造成的各行业人权侵犯问题。人不能被算法反控制。而在大洋彼岸某个大国,所有的公民已经接受了时刻被监控,还为支付宝人脸识别功能的便捷而感到骄傲……部分观点还是局限,这种议题哪里缺席讨论就哪里误会加深,有什么办法呢哎……

本片是凯西·欧尼尔《大數據的傲慢與偏見》一书的延展。这是个演算法包围现代公民的时代!演算法在幕后影响着我们生活的各种决定,包括我们上什么学校、能否借到汽车贷款,以及医疗保险必须支付多少保费,愈来愈多判断是由数学模型,而非某些人所做出。这一切看似公平:因为所有人是根据相同的规则评断,不受偏见影响。对热情的“问题解决者”来说,大数据像仙境,它搜集资讯、再运用数学模型,使我门得以更有效地调配资源、筛选最优的人事物、并做出最好的决定,这些热情的宣扬者更是四处宣传大数据应用的威力。但是,曾在典型数据分析圈内工作的凯西·欧尼尔不是上述这种人。她在《大數據的傲慢與偏見》中指出,事实与我们想的恰恰相反!这些数学模型不透明、不受管制,即便出错,受害者往往无法申诉。最令人不安的是,这些模型会“强化歧视”,例如,贫穷学生在申请学贷时,可能因自家的邮递区号,被审核贷款的数学模型视为还款高风险者,因而无法获得贷款……。这类问题会形成恶性循环——奖励幸运儿、惩罚遭践踏的人,创造出危害民主的“有毒鸡尾酒”。欢迎认清大数据的黑暗面,欧尼尔在《大數據的傲慢與偏見》中揭开对我们人生各阶段有巨大影响的各种黑箱数学模型,不管我们愿不愿意,演算法系统都已经为我们打上“分数”。当前许多数学模型已经失控滥用、还自作主张地替教师和学生评鉴、筛选履历表、审核贷款、评估员工绩效、锁定目标选民、决定假释名单,以及监测我们的健康状态,决定我们个人及社会的未来。欧尼尔呼吁:在这个人人都被迫拥有自己在某种演算系统中持有“e化评分”的时代,那些建立模型的人应该为他们所创造出来的演算法负起更多责任,而政策制定者更应该负起监督管理的责任。这本重要著作使我们得以提出关键问题、揭露这些“数学毁灭性武器”的真相和要求变革。本片是此书的延展。

Sorry,此资源仅限本站vip会员下载,请先登录

如下载地址失效,请联系我们的在线客服!帮助及声明:若需要帮助,您可以查看 帮助中心 。若本内容无意侵犯了贵司版权,请与我们联系2406067889@qq.com,我们将在第一时间处理与回复!